监控全绿,但业务已经“半死不活”,你一定见过这种场景

凌晨 1 点,群里突然炸了。

客服:

「用户一直在投诉,页面转半天打不开。」

老板:

「系统是不是挂了?」

你第一反应是打开监控大盘。

CPU 正常。

内存正常。

磁盘正常。

接口成功率 99.9%。

一片绿色。

你盯着屏幕,愣了 10 秒。

监控没问题,但业务明显不对。

如果你做过运维、当过技术负责人,或者是那个“被迫兼职运维的研发”,你一定见过,甚至正在经历这样的场景。

这类问题最难受的地方在于:

系统没有宕机

告警一条都没响

但用户就是用不了

你没法拍着桌子说“这是事故”,

也没法淡定地说“系统一切正常”。

最后往往变成一句苍白的解释:

“我再查一下……”

而老板心里想的是:

“不是有监控吗?怎么一点用都没有?”

在江苏立维做运维服务的这些年,我们复盘过大量线上问题。

有一个结论非常扎心:

很多中小企业的监控,只能证明一件事:

服务器还活着。

但它完全回答不了下面这些问题:

用户访问是不是真的慢了

核心接口是不是卡在某个环节

请求是不是大量堆积但没失败

系统是不是已经进入“亚健康状态”

于是就出现了一个极其常见、但又极其危险的状态:

业务已经“半死不活”,但监控告诉你:一切正常。

很多团队其实很努力了:

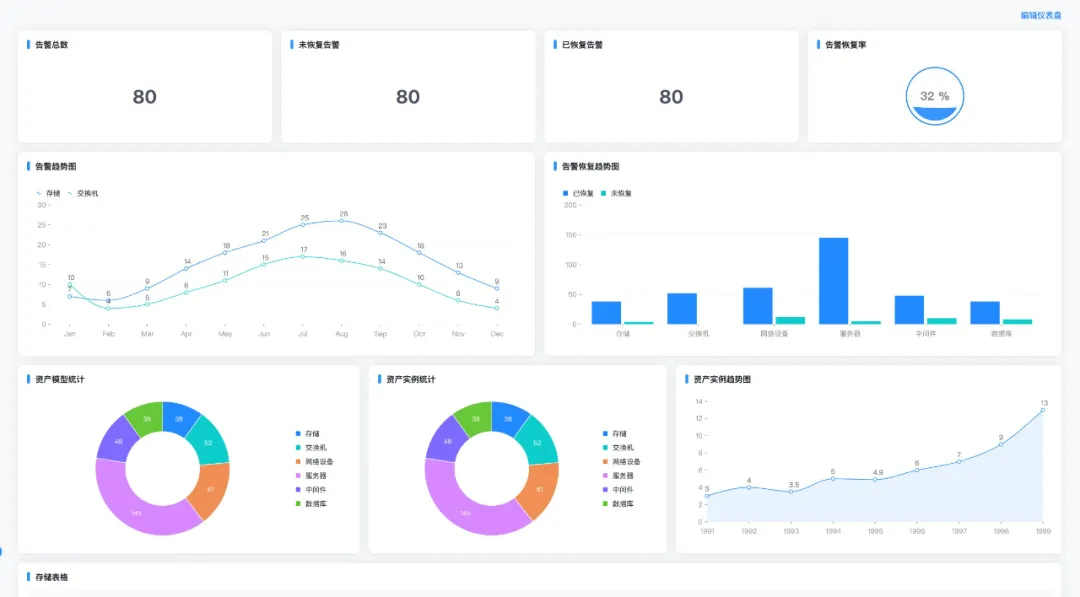

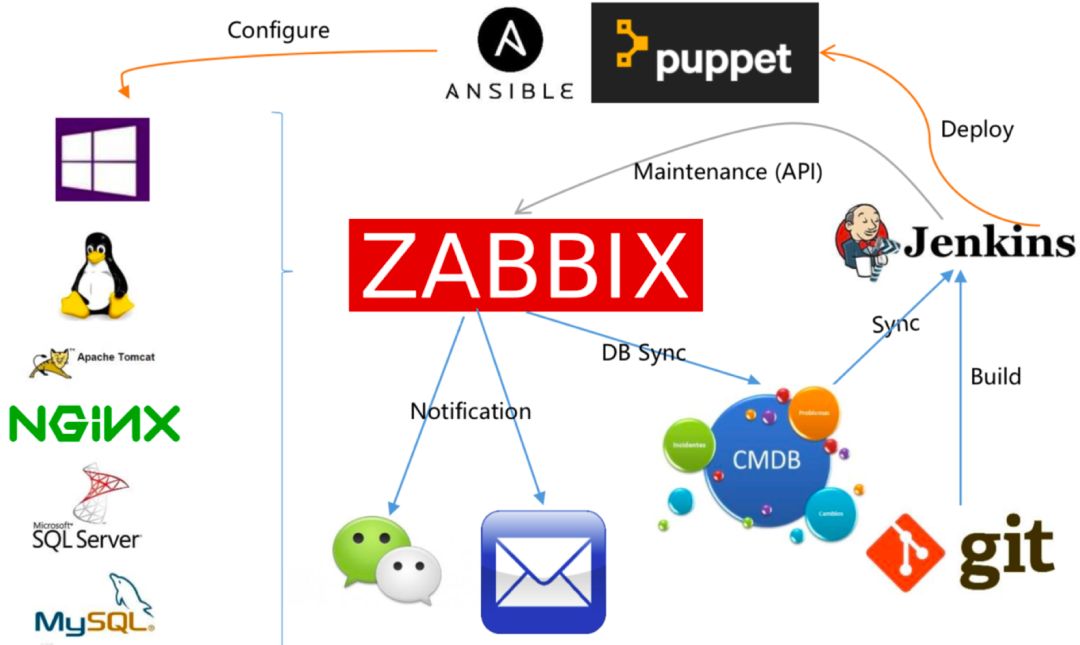

装了 Zabbix / Prometheus

CPU、内存、磁盘、网络一应俱全,

看板也做得很漂亮

但这些监控,本质上都在回答一个问题:

“机器有没有挂?”

而真正影响用户体验的问题,往往发生在另一个层面:

线程池被慢请求占满

下游接口偶发性超时

数据库连接池耗尽

GC 频繁但未到告警阈值

某个功能点响应时间悄悄翻倍

这些问题的共同特点是:

不致命

不报错

但持续折磨用户

因为中小团队往往有 3 个现实限制:

监控设计靠“顺手”

能监控什么,就监控什么,很少反问一句:

“这些指标,真的能反映业务是否正常吗?”

没人长期盯“趋势”

只在出问题时看监控,很少做趋势分析和异常对比。

没有 7×24 的响应机制

问题发生在凌晨、周末、假期时,

发现得晚 + 定位得慢 = 用户先骂,老板先急。

我们一直强调一句话:

监控不是为了证明系统还活着,

而是为了第一时间发现:业务开始不对劲了。

这意味着监控体系至少要回答 3 个问题:

用户是不是变慢了?

核心链路是不是在退化?

如果现在出问题,有没有人能立刻响应?

如果监控只能在“系统彻底挂掉”时告诉你结果,

那它更多是一份事故报告,而不是风险预警。

很多公司在复盘事故时,最后都会落在一句话上:

“监控我们也做了,但还是没拦住。”

问题往往不在工具,而在于:

监控是否围绕业务设计

告警是否真的有人响应

出问题时,是否有人能第一时间介入并处理。

稳定性,从来不是靠一个系统保证的,

而是靠一整套机制和责任闭环。